당뇨 합병증을 진단하는 안과 인공지능

이번에는 안과 영역의 의료 영상 데이터 분석으로 넘어가 보자. 일반인에게도 ‘당뇨병 환자가 합병증으로 실명의 위험이 높다’는 사실은 잘 알려져 있을 것이다. 이는 당뇨성 망막병증(diabetic retinopathy)이라는 망막에 생기는 당뇨병 합병증 때문이다. 이러한 당뇨성 망막병증을 딥러닝 기반의 인공지능이 안과 전문의보다 더욱 정확하게 판독할 수 있다는 연구가 2016년 11월 미국의학회지(JAMA)에 발표되었다.

이 연구는 발표되었을 때 의료계에서 여러모로 화제를 불러일으켰다. 특히, JAMA는 의학연구자라면 누구나 아는 세계적으로 저명한 의학 전문 학술지인데, 이 학술지에 연구를 발표한 것이 다름 아닌 구글이었기 때문이다. 세계적 ‘의학’ 저널에 ‘구글’이 ‘인공지능’ 논문을 발표했다는 것은 의료계 연구자들에게 매우 낯선 일이었다. 참고로 이 논문은 인공지능의 실력뿐만이 아니라, 데이터를 학습시키는 방법 등 의료 인공지능 연구를 진행하는 방법론 측면에서도 참고할 것이 많은 논문이다. 관련 분야에 있는 분은 (아직도 이 논문을 읽어보지 않았다면) 원문을 꼼꼼하게 읽어보는 것을 권한다.

당뇨병은 전 세계적으로 19명 중의 한 명이 겪을 정도로 흔하고도 심각한 질병이다. 당뇨병 환자들은 혈당을 적정한 수준으로 조절하지 못하기 때문에 장기적으로 여러 합병증으로 고통받게 된다. 그중에 가장 대표적인 것이 바로 당뇨성 망막병증(Diabetic retinopathy)이라는 안과 질환이다. 이 질병은 당뇨병력이 30년 이상인 환자의 90%에게 발병하며, 세계 각국에서 실명의 주요 원인이 되고 있다. 이 당뇨성 망막병증 환자는 세계적으로 빠르게 증가하고 있으며, 약 4억명 이상의 환자들이 위험군에 속한다.

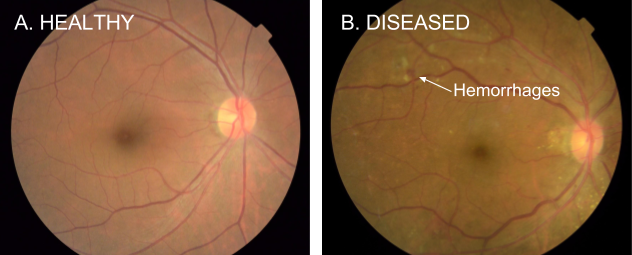

당뇨성 망막병증을 진단하기 위한 가장 일반적인 방법은 안과 전문의가 안저(안구의 안쪽)를 사진으로 찍어서 판독하는 것이다. 안과 전문의들은 이 안저 사진을 눈으로 판독하여, 망막 내 미세혈관 생성이나, 출혈, 삼출물 정도를 파악하여 이 질병의 진행 정도를 판단하게 된다.

당뇨성 망막병증의 진단을 위하여 찍은 안저 사진의 예시. (A)는 건강한 환자, (B)는 당뇨성 망막병증 환자.

(B)에서는 여러 군데의 출혈(hemorrhages)을 관찰할 수 있다. (출처: Google Research Blog)

인공지능 안과의사의 필요성

당뇨성 망막병증은 적절한 시기에 진단을 받고 치료를 시작하면 실명 가능성을 현저히 낮출 수 있다. 하지만 문제는 전 세계적으로 안과의사가 크게 부족한 곳이 많다는 것이다 [1, 2, 3]. 선진국에서는 고령화로 수요가 늘어나기 때문이며, 저개발국가에서는 배출되는 의사가 적기 때문이다. 특히 저개발국가일수록 상황은 심각하다. 2012년 한 안과 전문 학술지가 192개국을 조사한 결과에 따르면, 인구 100만 명 당 안과 전문의가 4명 이하인 나라는 30개국이나 된다. 반면 인구 100만 명 당 안과의사가 100명 이상인 나라는 18개국에 지나지 않는다.

또한 당뇨병 환자의 많은 수가 후진국에 살고 있다는 점도 문제다. WHO가 2016년 4월 발표한 ‘세계 당뇨병에 관한 보고서’에 따르면 당뇨병 유병률은 선진국에 비해서 후진국에서 크게 증가하고 있다. 즉, 저개발국가의 경우 당뇨병 유병율이 크게 증가하고 있으나, 합병증인 당뇨성 망막병증을 진단할 수 있는 안과 의사의 수는 매우 적다.

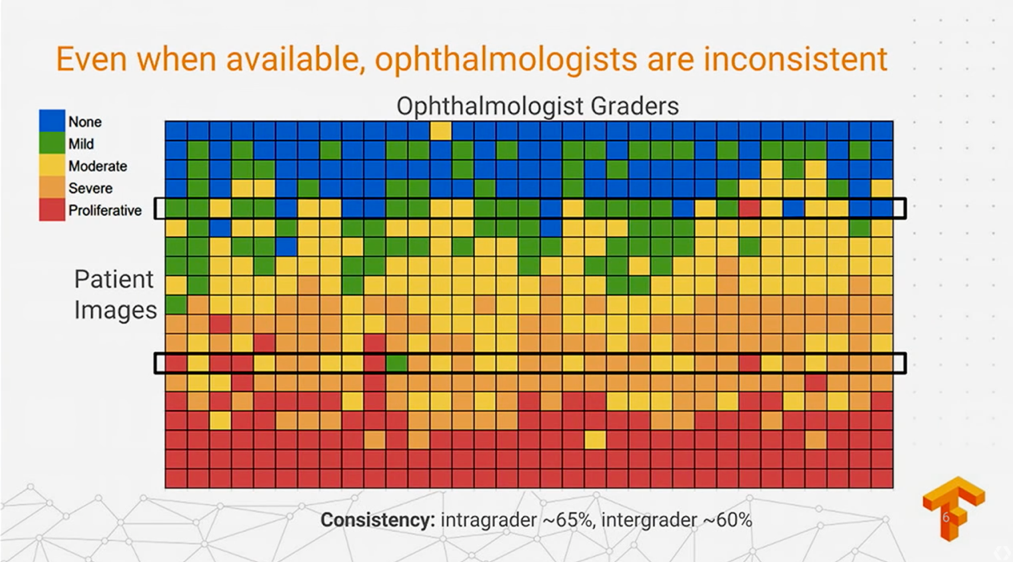

또 다른 문제는 안과 의사들 사이에서도 판독 결과에 대한 큰 격차가 존재한다는 것이다. 아래 그림은 이번 연구와 관련해서 구글이 제시한 결과 중 하나로, 같은 환자에 대해서 안과 의사들 사이에 판독 결과에 일관성이 낮을 수 있음을 잘 보여주고 있다. 파란색은 당뇨성 망막병증이 없는 것이고, 이 색깔이 붉은색에 가까워질수록 당뇨성 망막병증이 심각하다는 것이다.

어떤 환자의 경우 대부분의 의사의 판독 결과가 비슷하기도 하지만, 몇몇 환자들의 경우(특히, 검은색 사각형으로 처리된 환자의 경우)에는 질병이 없다는 것부터 당뇨성 망막병증이 심각하다는 해석까지 모두 나오는 경우도 있다. 이렇게 안과의사들 사이에서도 편차가 존재하는 것은 실력의 차이일 수도 있고, 그날의 컨디션 차이일 수도, 혹은 해당 환자의 사례가 특히 애매하기 때문일 수도 있다.

다시 말해 안과의사도 인간이기 때문에 인간으로서 가지는 인지능력의 한계는 존재하기 마련이다. 이런 경우에 인간의 인지 능력의 한계를 뛰어넘는 인공지능을 적용하면 안과의사의 능력을 보조하여 판독의 일관성과 효율성을 높이거나, 혹은 그 자체로 안과의사보다 더 정확한 성능을 보여줄 수도 있다. 이러한 측면에서 안저 사진의 판독은 의료 분야에서 딥러닝이 가장 우선적으로 적용될 수 있는 문제 중 하나로 손꼽혀왔다.

안과 전문의들 사이에서도 판독 결과가 다른 경우가 많다 (TensorFlow Dev Summit 2017)

안과 전문의들 사이에서도 판독 결과가 다른 경우가 많다 (TensorFlow Dev Summit 2017)

구글의 인공지능 안과의사

구글은 CNN을 이용하여 안저 사진을 분석하여 당뇨성 망막병증을 진단할 수 있는 딥러닝 기반의 인공지능을 만들었다. 특히 우리가 주목할만한 것은 딥러닝이 학습할 수 있는 데이터를 만들었던 과정이다. 구글은 미국의 안과 전문의 및 고년 차 레지던트 54명을 고용하여, 무려 13만 장에 가까운 방대한 안저 사진을 3~7회에 걸쳐서 중복 판독시켰다. 이는 앞서 언급한 안과의사들 사이에 발생할 수 있는 판독 편차를 여러 명의 의사가 중복 판독함으로써 해결하려고 한 것이다. 이 판독은 2015년 3월부터 12월에 걸쳐 이뤄졌으며, 참여한 의사 한 명당 평균적으로 9,774장의 안저 이미지를 판독했다.

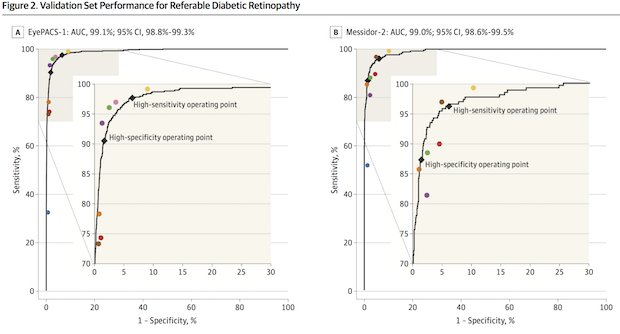

구글은 이렇게 만든 학습 데이터를 인셉션 모델에 ‘전이 학습’ 시켜서 안저 사진을 판독하는 인공지능을 개발했다. 이렇게 개발한 인공지능을 EyePACS-1 과 Messidor-2 라는 잘 알려진 대규모 안저 사진 데이터에 대해서 검증하였다. EyePACS-1은 4,997명의 환자로부터 얻은 9,963개의 안저 사진으로 구성되어 있으며, Messidor-2는 874명의 환자의 1,748개의 안저 사진으로 구성된다. 인공지능의 성능을 검증하기 위해서 ROC 커브를 그렸을 뿐만 아니라, 이 연구에 참여했던 54명의 의사 중에 일관된 판독을 보여주었던 7~8명의 판독 결과와 비교해보았다.

그 결과 이 인공지능의 성적은 매우 우수했다. EyePACS-1 과 Messidor-2 의 두 테스트 셋에 대해서 ROC 커브를 그려보면, 그림과 같이 매우 우수하게 나온다. (그림에서 곡선이 좌상단에 붙을수록 성능이 우수한 것이다) EyePACS-1 과 Messidor-2 의 두 테스트 데이터에 대한 AUC 값은 각각 무려 0.991, 0.990에 달한다. (AUC 값이 1이면 100% ‘완벽’하다는 것을 다시 한번 상기해보자.) 참고로 이 연구가 진행될 당시에 활용된 인셉션 버전3는 이미 옛날 버전이며, 현재 그 다음 버전인 4가 공개되었다. 업데이트된 버전의 아키텍처의 성능은 당연히 더 좋으며, 동일한 데이터를 인셉션 v4에 학습시킨다면 성능은 아마도 더 개선될 것이다.

거의 완벽한 성능을 보여주는 구글의 인공지능 (출처: JAMA)

거의 완벽한 성능을 보여주는 구글의 인공지능 (출처: JAMA)

인간 안과의사의 판독을 능가

특히, 위의 그래프에서 보면 색깔별로 표시된 동그란 점들이 있다. 이 점들은 구글의 인공지능 학습에 사용된 안과 전문의 7-8명의 성적을 나타낸 것이다. 이 점들이 ROC 곡선의 위에 위치하면 인공지능보다 나은 성적을 보여준 의사들, 곡선보다 낮은 곳에 위치하면 인공지능보다 판독 성적이 좋지 않은 의사들이다. 점들의 대부분이 ROC 곡선의 주위에 위치한다는 것을 보면 인공지능의 성능이 안과 전문의와 거의 동등한 수준이라는 것을 알 수 있다.

더 나아가, F-score로 비교해보면 인공지능의 판독 성능이 안과 전문의보다 더 우수한 것으로 드러났다. (footnote: F-score는 민감도와 특이도를 모두 고려한 수치라고 보면 된다. 더 정확하게는 정밀도(precision)와 재현율(recall)의 조화평균값이다.) 안과 전문의들의 F-score는 0.91인 것에 비하여, 구글 인공지능은 0.95로 약간 더 높았다. 특히, 이 7-8명의 의사들이 인공지능 학습 데이터를 만들었던 54명의 의사 중에서 우수한 분들임을 고려하면, 구글의 인공지능은 평균적인 안과 전문의보다 적어도 안저 판독에 대해서는 더 정확하다고 주장해도 무리가 없을 것이다. 또한 논문에서는 당뇨성 망막병증의 중증도나 안저 사진의 퀄리티, 동공확대를 시킨 사진과 그렇지 않은 사진 등 다양한 조건으로 구글의 인공지능의 성능을 테스트 해보았으나, 그 정확성은 크게 변하지는 않았다.

구글의 전설적인 개발자 제프 딘(Jeff Dean)은 구글의 이 연구 결과를 발표한 블로그에서 “기계 학습 모델이 당뇨성 망막병증의 판독에 대해서 평균적인 안과 전문의보다 성적이 더 좋다(A machine learning model that is better than the median board-certified ophthalmologist in assessing signs of diabetic retinopathy)” 고 이야기하기도 했다.

이러한 인공지능의 가장 큰 장점은 안저 데이터에 대해서 일관적인 판독을 높은 정확도, 즉 민감도와 특이도가 매우 높은 수준으로 해준다는 것이다. 과거에도 안저 사진을 판독하는 많은 연구에서 민감도와 특이도 둘 중 하나는 90% 후반대까지 기록한 경우가 있었으나[1, 2, 3, 4], 이 연구처럼 민감도와 특이도 모두 높은 수치를 얻지는 못했다.

이러한 인공지능은 사용 목적에 따라 여러 형태로 활용할 수 있다. 특히 대량의 데이터를 처리해야 하는 검진 센터 등에서 이러한 인공 지능이 인간 의사와 함께 판독에 참여하여, ‘혹시 인간 의사가 놓친 당뇨성 망막병증이 없는지’ 를 파악하기 위해서 민감도를 극대화하여 사용할 수 있다. 혹은 안과의사가 부족한 저개발국가에서는 의사에게 진료 받기 전에 당뇨성 망막병증의 위험군을 미리 골라내기 위해서 특이도를 극대화하여 사용해볼 수도 있을 것이다. (특이도는 ‘질병이 없는’ 사람을 검사하여, ‘질병이 없다’고 정확하게 판단하는 비율이므로, 의사에게 추가적인 검진이 필요 없는 사람을 정확하게 골라낼 수 있다)

피부암을 진단하는 인공지능

이번에는 피부과의 의료 영상 데이터 분석 연구를 살펴보자. 스탠퍼드 대학교의 연구진은 피부암을 피부과 전문의 수준으로 정확하게 진단할 수 있는 인공지능을 딥러닝으로 개발했다. 2017년 2월 네이처에 발표된 이 연구에서 인공지능은 피부 병변 사진의 판독에 대해 피부과 전문의보다 나은 실력을 보였다. 앞서 소개한 구글의 당뇨성 망막병증 판독 인공지능에 이어 몇달 지나지 않아 발표된 이 연구는 마찬가지로 의료계의 큰 관심을 끌었다.

피부암은 매년 미국에서만 540만 명의 신규 환자가 발생할 정도로 빈번한 질병이다. 특히, 피부암은 조기 발견이 중요하다. 피부암 중에서 가장 악성이며 예후가 좋지 않은 흑색종(melanoma)의 경우 조기에 발견하면 5년 생존율이 97%로 양호하지만, 말기에 발견하면 14%로 매우 낮기 때문이다. 하지만 피부암은 초기에 자각 증상이 없는 경우가 많고, 피부에 있는 다른 점, 검버섯, 사마귀와 구분이 어려운 경우가 많으므로 환자들은 출혈 등의 이상 증상이 생긴 다음에야 뒤늦게 병원을 찾는 경우가 많다.

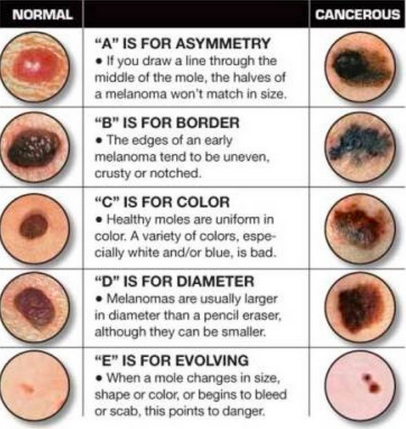

의사들은 흑색종 의심 병변을 구분하기 위해서 소위 ABCDE라는 기준을 사용한다. 일반적인 점과 흑색종을 구분할 수 있는 기준을 간략히 표현한 것으로 점의 좌우가 대칭적인지(Asymmetry), 경계가 명확한지(Border), 색깔이 단일한지(Color), 특히 흰색이나 파란색이 섞여 있지 않은지, 직경이 6mm를 넘지 않는지(Diameter), 점의 크기나 모양 및 색깔이 시간이 지남에 따라서 변화(Evolving)하고 출혈이 있는지가 기준이다.

즉, 이렇게 피부과 전문의도 일단 의심스러운 병변을 눈으로 보거나, 혹은 일종의 휴대용 현미경인 더마토스코프 (dermatoscope)을 사용해서 진단을 내리게 된다. 더마토스코프는 저 배율로 피부를 확대해서 맨눈으로 관찰하기 어려운 피부의 색조변화 등 형태학적 특성을 관찰할 수 있으므로 진단에 도움이 된다. 피부과 의사에게 청진기와 같은 도구라고 할 수 있다. 만약 이런 검사에서 결론을 내리기 어렵거나, 암이 의심될 경우에는 병변을 직접 떼어내어 (이를 생검(biopsy)이라고 한다), 병리과에서 조직 검사를 통해 암인지, 어떤 암인지, 몇기인지 등을 확진하게 된다.

이렇게 피부암의 의심병변인 경우에도 우선 피부과 전문의들이 ‘시각적 인지능력’을 바탕으로 진단하게 된다. 이 부분에서 앞서 소개한 연구들과 마찬가지로 인공지능을 적용할 수 있다.

피부암에 인공지능을 적용한다면

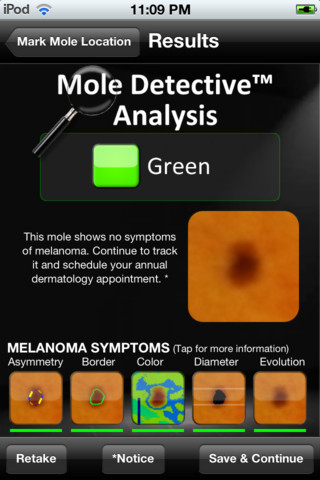

사실 피부암은 예전부터 기계학습의 이미지 인식 기술을 활용하여 판독을 시도해오던 분야다. 심지어는 스마트폰 카메라로 찍은 사진을 통해 흑색종을 진단해주겠다는 어플리케이션도 여럿 나와 있을 정도다. 하지만 그 정확도는 높지 않았고, 정작 의료기기 인허가를 받은 것도 별로 없었다. 그래서 미국에서는 흑색종을 ‘진단할 수 있다’고 과대 주장하는 멜앱(MelApp)과 몰디텍티브(Mole Detetive)라는 두 앱이 미국의 공정거래위원회(FTC)에서 2015년 2월 벌금을 부과받은 사례도 있다.

이러한 기존 앱의 정확도에 대해서 2013년 4월에 JAMA 더마톨로지에 출판된 논문을 참고할만 하다. 이 연구가 어떤 내용인지는 논문의 제목만 보면 쉽게 알 수 있다. 제목이 “흑색종 검출을 위한 스마트폰 어플리케이션의 진단 부정확성(Diagnostic Inaccuracy of Smartphone Applications for Melanoma Detection)”이기 때문이다.

이 연구에서는 흑색종을 진단해주겠다는 네 가지 익명의 스마트폰 앱의 정확성을 분석했다. 흑색종 및 정상 사진을 앱으로 분석하고, 이 결과를 피부과 전문의들의 판독과 비교하여 정확성을 평가했다. 그 분석 결과, 네 개의 앱들 사이에서도 흑색종 판독 결과가 매우 편차가 컸다. 특히, 30% 이상의 경우에 잘못된 판독을 내렸는데, 이미지 분석 알고리즘을 통해 자동으로 판독해주는 앱의 정확도가 상대적으로 더 좋지 않았다. 그나마 정확도가 괜찮았던 앱은 이미지를 원격으로 피부과 전문의에게 전송해서 판독을 해주도록 하는 앱이었다.

이 결과만 놓고 보면 꽤나 실망스러운 결과라고 할 수 있다. 그런데 이 연구는 2012년에 제출된 논문으로, 연구 시기를 고려해보면 알렉스넷을 통해서 CNN이 대두되기 이전에, 기존이 기계학습 방법으로 개발된 앱을 연구했다. 동일한 목적의 앱을 딥러닝을 기반으로 만들면 결과가 완전히 달라질 것이라고 예측하던 와중에, 실제로 그러한 결과가 네이처 논문으로 출판된 것이다.

딥러닝의 피부암 데이터 학습

이 연구에서 스탠퍼드 연구진들은 역시 CNN 을 활용하여 방대한 양의 피부 병변 이미지를 학습시켰다. 피부암에 대해서는 심층신경망에 학습시킬 정도로 충분히 많은 양의 데이터가 없었기 때문에 연구자들은 이 데이터부터 직접 만들어야 했다.

연구자들은 방대한 양의 피부 병변 데이터들을 스탠퍼드 병원 자체 데이터를 포함한, 에든버러 대학의 이미지 라이브러리 등 여러 연구소의 데이터베이스 등 긁어 모았다. 이 병변의 이미지들은 각도, 배율, 밝기 등이 저마다 달랐는데, 18명의 의사가 참여하여 이 사진들을 일일이 판독하는 무지막지한 과정을 거쳤다.

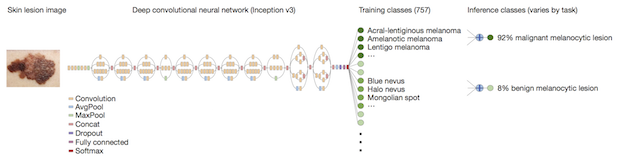

또한, 체계적으로 질병명을 지정해야 학습과 검증에 용이하므로, 아예 다양한 피부과 질병의 계층 관계(taxonomy)를 정의하기도 했다. 그 결과 2,000개 이상의 질병으로 체계적으로 판독된 무려 13만 장의 피부 병변 이미지 데이터를 만들 수 있었다. 이렇게 만든 피부 병변 데이터를 이번에도 구글의 인셉션 v3 아키텍쳐를 약간 변형시켜서 ‘전이 학습’ 시킴으로써 피부암을 판독하는 인공지능을 만들 수 있었다.

구글의 인셉션 v3를 이용하여 피부 병변 이미지를 학습 (출처: 네이처)

인공지능의 피부암 진단 정확도

이렇게 개발한 인공지능의 성능을 검증하기 위해서 조직검사를 통해 기존에 확진해놓은 피부 병변 이미지를 활용했다. 특히, 의학적으로 구분이 중요한 세 가지 경우에 대해서 테스트를 진행했다.

- 표피세포 암(keratinocyte carcinoma)과 지루각화증(검버섯, benign seborrheic keratosis)의 구분

- 악성 흑색종과 양성 병변 구분 (일반 이미지 기반)

- 악성 흑색종과 양성 병변 구분 (더마토스코프로 촬영한 이미지 기반)

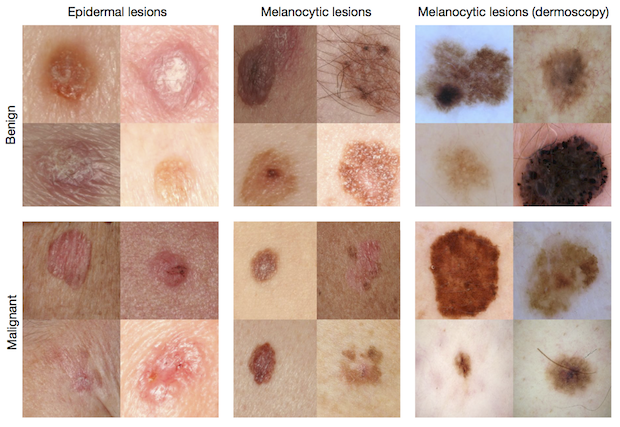

아래의 사진에는 이러한 세 가지 경우에 해당하는 사진의 예시들이 나온다. 위쪽 사진이 양성(benign)이고 아래쪽 사진이 악성(malignant) 사진인데 언뜻 눈으로 보아서는 앞서 언급한 ABCDE를 기준으로 하더라도 구분이 쉽지 않다.

양성(윗줄)과 악성 종양(아랫줄) 이미지의 예시 (출처: 네이처)

양성(윗줄)과 악성 종양(아랫줄) 이미지의 예시 (출처: 네이처)

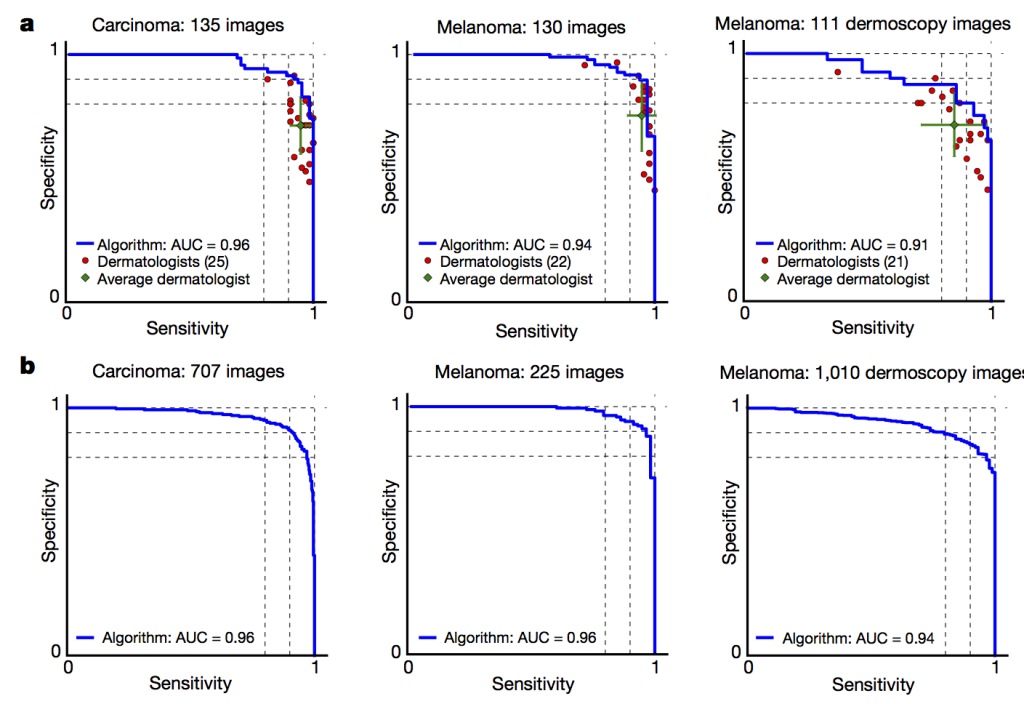

세 가지 경우에 해당하는 각각 135개, 130개, 111개의 피부 병변 이미지로 인공지능의 판독 결과와 21명 이상의 피부과 전문의들의 판독 결과를 비교해보았다. 그 결과 놀랍게도 세 경우 모두 인공지능의 판독 성적이 인간 피부과 전문의들을 능가했다. 이번에도 ROC 곡선을 그리고, 곡선 아래의 면적인 AUC 값을 계산하여 인공지능의 성능을 평가해보았다. (앞선 ROC 곡선과는 달리 좌우가 반전되었음에 유의하자. 이번 곡선은 오른쪽 위로 갈수록 더 정확한 것이다) AUC 값은 각각 0.96, 0.94, 0.91 으로 매우 높게 나왔다.

또한 그림의 a 패널에서 붉은색 점은 피부과 전문의들의 판독 정확도를 보여주는 것이다. 즉, 파란색 선의 왼쪽, 아래에 붉은 점들이 다수 있다는 것은 인공지능보다 정확성이 낮은 피부과 전문의들이 상당수 있다는 의미다. 또한 의사들 성적의 평균을 나타내는 초록색 점 역시 파란선 아래에 있으므로, 피부과 전문의들의 평균 성적 역시 인공지능에 비해 좋지 않다는 것을 보여준다.

b 패널에서는 테스트 데이터를 각각 707개, 225개, 1,010개로 늘렸을 경우에 인공지능의 성능이 여전히 유지된다는 것을 보여주고 있다. AUC 값이 a 패널에 비해서 오히려 더 약간씩 상승한 것을 알 수 있다. 사실 논문의 제목이나 이 연구를 보도한 기사들에서는 ‘피부과 전문의 수준’의 인공지능이라고 언급하고 있으나, 논문의 데이터를 보면 적어도 사진을 바탕으로 한 피부암 판독에 관해서는 인공지능이 평균적인 피부과 전문의들의 실력을 능가하고 있다.

딥러닝과 피부과 전문의의 피부암 이미지 판독 정확도 비교 (출처: Nature)

스마트폰을 통한 피부암 검사

연구진들이 직접 밝힌 이번 연구의 의미 중 하나는 의료 접근성이 떨어지는 곳, 특히 피부과 전문의가 없는 곳에서도 스마트폰만 있으면 딥러닝을 통해 흑색종을 진단할 수 있는 가능성을 열었다는 것이다. 앞서 소개한 2013년 JAMA 더마톨로지 논문에서는 기존의 스마트폰 앱의 부정확성에 대한 논문을 소개하고 있지만, 이제는 딥러닝을 통해서 앱으로도 더 높은 정확도로 판독이 가능해진 것이다. 이 역시 의사나 검사 장비가 부족한 곳에서도 진료를 할 수 있는, 의료의 민주화를 구현하는데 도움이 될 것이다.

실제로 논문의 주저자 중 한 명인 스탠퍼드 대학의 브렛 쿠프렐(Brett Kuprel)은 2017년 한 인공지능 학회에서, 이 인공지능이 스마트폰에서 구동되는 것을 직접 시연하기도 했다. 시연을 보면 피부 병변 사진에 스마트폰을 가져다 대면 거의 실시간으로 악성 피부암일 확률과 양성일 확률 등이 계산되어 나오는 것을 알 수 있다.

더 나아가서는 스마트폰에 더마토스코프를 부착하여 피부 병변을 촬영하고, 이를 인공지능으로 판독하는 것도 생각해볼 수 있다. 스마트폰용 더마토스코프는 이미 시중에 다양한 형태로 판매되고 있다. 대부분 $100 내외의 가격이면 스마트폰 카메라에 렌즈를 부착하여 의료 전문가가 사용하는 수준으로 사진을 찍을 수 있다.

연구진은 이 인공지능이 스마트폰으로도 작동됨을 시연했다 (TensorFlow Dev Summit 2017)

연구진은 이 인공지능이 스마트폰으로도 작동됨을 시연했다 (TensorFlow Dev Summit 2017)

양적, 질적으로 우수한 데이터

이번에 살펴본 구글의 당뇨성 망막병증 판독 인공지능과 스탠퍼드 대학의 피부암 판독 인공지능 연구는 방법론적으로 유사한 부분이 많다. 의료 영상 학습 데이터를 구성한 다음, 잘 증명된 구글의 딥러닝 아키텍처를 바탕으로 전이 학습시켜 인공지능을 만들고, 이를 인간 전문의와 정확성을 비교했다는 것이 이 두 연구의 골자이다.

여기서 주목해야 할 것은 인공지능을 개발하기 위해 양적으로도, 질적으로도 매우 우수한 데이터를 직접 만들었다는 점이다. 구글의 연구에서는 안과 의사 54명이 참여하여 13만 장에 가까운 안저 사진을 5개의 등급으로 3~7회 중복해서 판독하였다. 구글에서는 의사들이 판독을 편하고 효율적으로 할 수 있도록 별도의 프로그램도 제공했다. 스탠퍼드의 피부암 인공지능 연구도 비슷한 규모인 13만 장 정도의 데이터에 18명의 의사가 직접 참여했으며, 판독과 학습에 일관성이 있도록 피부과 질환에 대한 계층을 새롭게 정의했다.

이렇게 딥러닝으로 우수한 성능의 인공지능을 만들기 위해서는 심층 인공신경망 자체의 디자인도 중요하지만, 어떤 데이터를 학습할지가 중요하다. 그 데이터는 단순히 얼마나 많은 양이냐도 관건일뿐만 아니라, 누가 어떻게 판독하고 어떠한 양식으로 정답을 달아놓은 양질의 데이터였는지도 역시 매우 중요하다.

이 연구들에서 우리는 방대한 데이터를 다수의 의사가, 다수의 등급으로, 중복 판독을 거친 데이터일수록 좋다는 교훈을 얻을 수 있다. 사실 이렇게 양적, 질적으로 우수한 데이터를 직접 만드는 일은 구글과 같은 대형 기업이 아닌, 개별 스타트업이나 개별 병원이 혼자서 하기 어려운 일일지도 모른다. 단적으로, 국내에 웬만한 대학병원을 보더라도 한 진료과에 50명 이상의 전문의가 소속된 병원은 없다. 이는 결국 우수한 인공지능을 만들기 위해서는 다수의 병원 및 기업 간의 협업이 필요하며, 이 과정에서 적절한 협업 체계 및 충분한 보상 체계도 갖출 필요가 있다.

또한 이러한 연구에서 인간 의사의 역할이 과연 무엇이었는지를 보면 여러 복잡한 생각이 든다. 단적으로 이야기해서, 연구에 참여한 의사의 역할이 인공지능이 학습할 데이터를 만들어주고, 학습 체계를 잡아주는 것, 그리고 그렇게 개발된 인공지능과 실력을 비교당하면서 결과적으로 인공지능의 우수성을 보여주는데 그치고 있기 때문이다.

더 무서운 것은 이러한 ‘인간’ 전문가들의 노력을 통해 특정 주제에 대해서 거의 완벽하거나 인간을 능가하는 인공지능이 만들어지면, 그 이후부터는 그 인공지능을 만드는데 기여한 인간 전문가들의 필요성이 (적어도 해당 문제에 대해서는) 줄어들 수밖에 없다는 아이러니다. 앞으로 이러한 방식의 인공지능 연구는 더 많이 쏟아질 것이며, 비록 개별 문제에 국한된다고 할지라도 ‘인간 의사와 맞먹는’, 혹은 ‘의사를 능가하는’ 실력의 인공지능이 늘어날 것은 자명하다.

(계속)

![[논문] LLM이 의료 전문가보다 의학 텍스트 요약을 더 잘 한다](https://www.yoonsupchoi.com/wp-content/uploads/2024/03/Untitled-5-140x90.png)

![[영상] 카카오 브레인의 배웅 최고 헬스케어 책임자(CHO) 님 인터뷰](https://www.yoonsupchoi.com/wp-content/uploads/2024/03/배웅-부사장님-140x90.jpg)

![[공지] DHP 디지털 헬스케어 아카데미 2024 (6기)의 수강생을 모집합니다!](https://www.yoonsupchoi.com/wp-content/uploads/2024/02/홈페이지-메인배너-이미지-copy-140x90.jpg)