ChatGPT나 PaLM 과 같은 LLM이, 더 나아가서는 Foundation Model 자체가 가장 활발하게 활용될 수 있는 분야 중의 하나가 의료입니다. 최근에 의료 분야의 ChatGPT의 활용 방안에 대한 논의가 계속되면서, 고민이 깊어지는 곳이 있습니다. 바로 FDA와 식약처와 같은 규제 기관입니다.

LLM은 여러가지 의미에서 인류가 그동안 접해보지 못했던 유형의 인공지능입니다. 이는 FDA와 식약처 같은 규제 기관의 입장에서도 마찬가지입니다. 그동안 ‘의료기기’라는 것을 정의하고, 허가하고, 규제하기 위해서 각국의 규제 기관들은 여러 법체계를 정비해왔는데요. 인공지능에 대해서도 마찬가지였지요.

(한국의 식약처는 FDA보다 더 선도적으로 이 규제를 정비해왔고, 때문에 IMDRF에서 의료 인공지능 분야 의장국이 되기도 하였습니다. 그 결과 식약처 주도로 개발한 인공지능 가이드라인이 국제 공통 가이드라인으로 IMDRF에서 공식 승인되기도 하였고요.)

하지만 이런 기존의 의료기기에 대한 원칙을 LLM에게 적용하기 위해서는 여러 가지로 난감한, 고민스러운 부분들이 존재합니다. 최근에 관련한 아티클들이 perspective, commet 섹션에서 쏟아지고 있는데요. 최근 Nature에 실린 아티클이 꽤 읽어볼만 합니다.

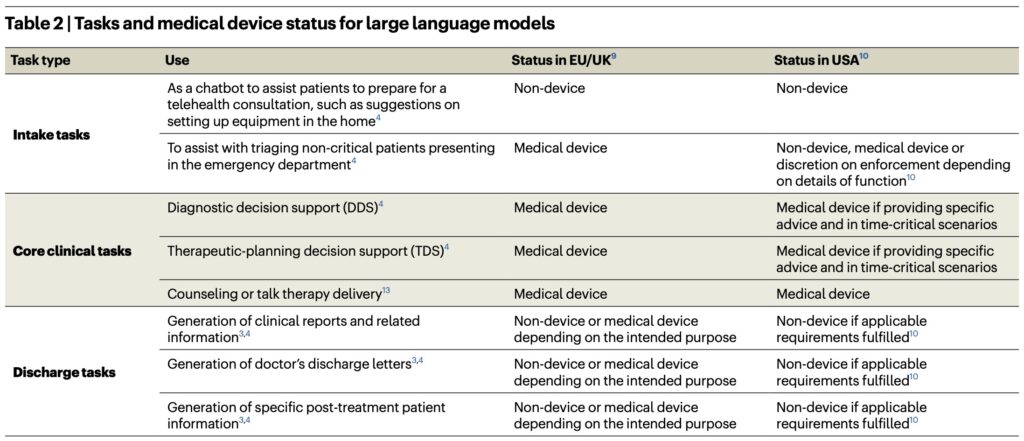

ChatGPT와 같은 LLM은 향후 일종의 CDS (Clinical Decision Support)의 형태로 활용될 가능성이 높습니다. 그렇게 활용을 시도한 논문도 많이 나오고 있고요. 그런데 현재의 미국과 유럽의 법체계 하에서는 이러한 CDS 소프트웨어는 많은 경우 의료기기에 해당합니다. 단순한 DB 기능 이상의 진단, 예방, 모니터링, 예후 예측, 치료, 질병 완화 등의 목적인 경우에는 모두 의료기기의 범주에 해당하지요. 더 자세히는 세부적인 기능이나 사용 목적에 따라서 의료기기 해당 여부가 조금씩 달라지는 경우도 있습니다만, 많은 경우 의료기기로 분류됩니다. (미국 보다는 EU 에서 의료기기로 더 많이 판단하게 됩니다.)

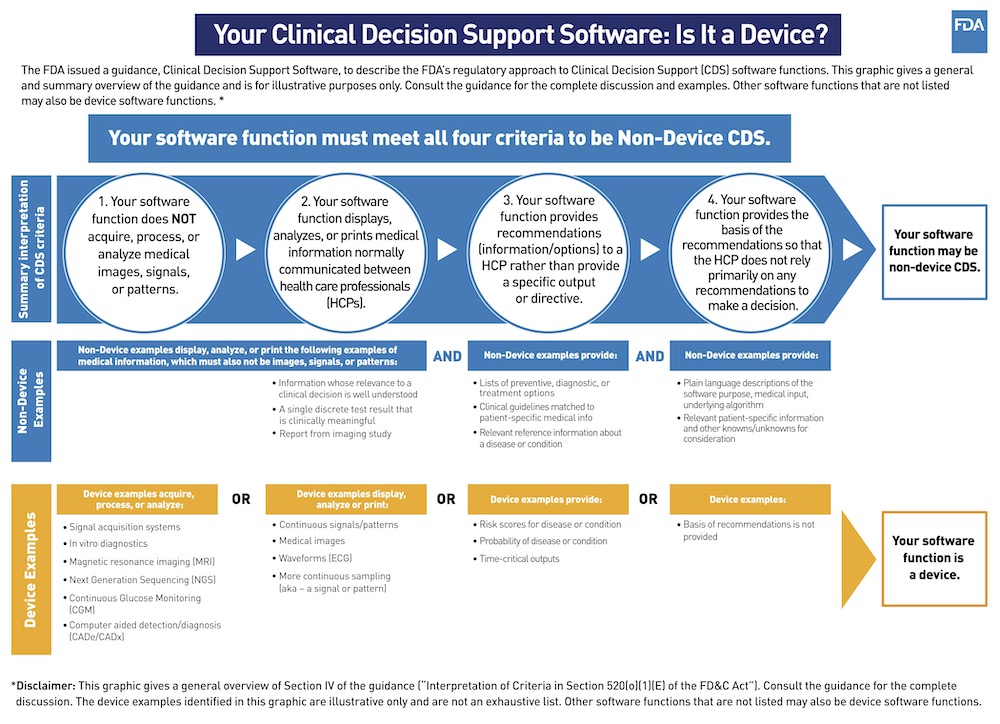

2022년 9월 FDA는 CDS의 의료기기 여부를 판별하는 기준을 가이드라인으로 내어놓은 바 있습니다. 현재 상태의 LLM은 정확한 답변을 주기 위해서 추가적인 정보를 요구하지도 않고, 답변의 신뢰도를 함께 보여주지도 않고, 답변의 출처를 알려주지도 않지요. FDA의 기준에 따르면 이러한 소프트웨어는 의료기기에 해당합니다. 아래의 그림을 참고하셔도 됩니다.

또한 (논문에 나오는 내용은 아니지만) 이러한 이유에서 최근 미국 FDA의 director 가 LLM을 의료기기로서 규제하겠다는 공식적인 입장을 표명하기도 했습니다. 하지만 이를 ‘어떻게’ 규제하겠다는 이야기는 하지 않았는데요. 아래와 같은 정도의 언급에 그쳤습니다. 그도 그럴 것이, ‘어떻게’ 규제할 것인가로 가면 답이 잘 안 나옵니다. 이 부분이 규제기관으로서는 골치아픈 부분입니다.

If we’re not nimble in the use and regulation of large language models, we’ll be swept up quickly by something that we hardly understand. The great things are really great: imagine a world in which your questions were answered immediately in language appropriate for your literacy and numeracy; also your clinician can actually talk with you rather than spending all their time cutting, pasting and writing clinic notes; I could go on and on, but I see the regulation of large language models as critical to our future.

무엇보다 ChatGPT와 같은 LLM은 범용 목적으로 활용할 수 있기 때문에, 특정한 사용 목적을 정의하기가 불가능합니다. 의료기기를 심사하기 위해서 사용 목적을 정의하는 것은 가장 기본적인 출발점에 해당합니다. 일단 이 출발점부터 난관에 부딛히는 것이지요. 더 나아가 LLM의 input과 output 모두 (거의) 무한대의 조합이기 때문에 사용성이나 정확성을 측정하기가 사실상 불가능합니다. 따라서, 기존에 FDA, 식약처가 인허가, 혹은 심사했던 모든 인공지능과 LLM이 이 측면에서 근본적으로 다릅니다.

LLM의 가장 큰 문제 중의 하나인 환각(hallucination) 이슈도 의료기기로서 정확성을 검증하기 위한 큰 장애물입니다. 이를 정량적으로 검증하기도 쉽지 않고, (어느 정도까지) 컨트롤 가능한 것인지도 아직은 불확실합니다.

더 나아가, 인허가 이전/이후에 모두, 알려진 리스크가 완화되었는지를 증명하기가 어렵고, input과 output 사이에 의학적 연관관계가 적절한지 증명하기도 어렵지요. 이러한 이유로 LLM은 EU에서 의료기기로 판매되기가 어려울 것이라고 합니다. EU에서는 출시 이후 감시 (PMS)와 clinical follow-up을 요구하는데 이는 LLM에게 아주 도전적인 과제입니다.

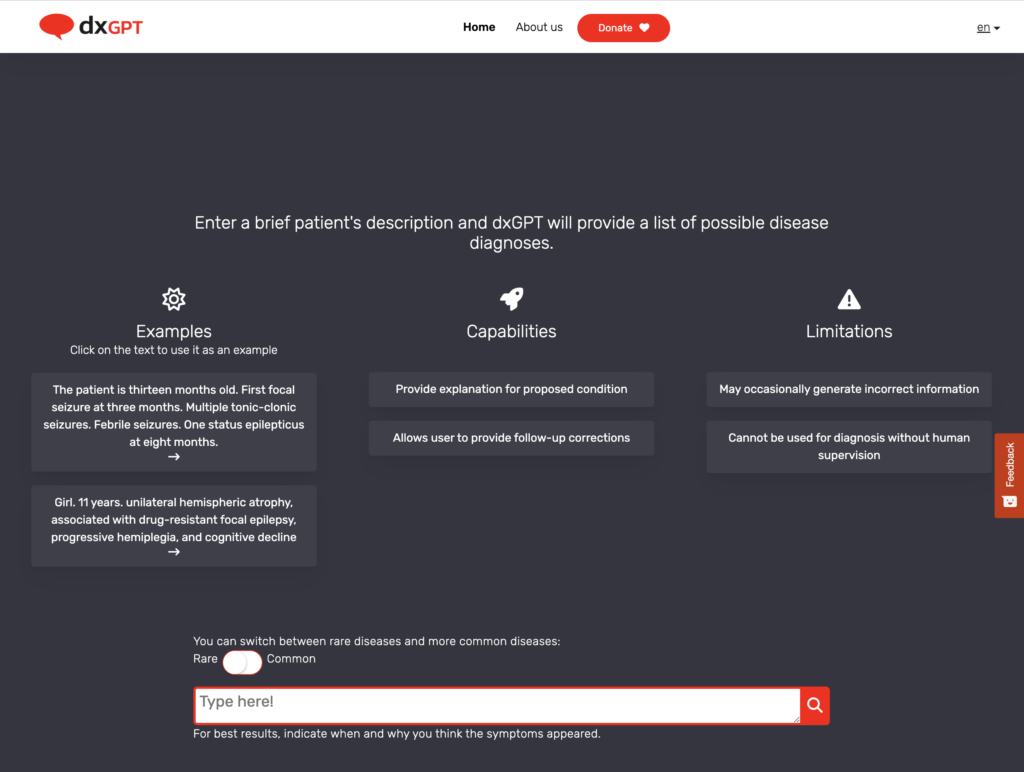

이러한 상황에서도 이미 몇몇 서비스들은 의학적인 목적으로 LLM이 환자 혹은 일반 대중들에게 의학적인 목적으로 활용되고 있음을 지적합니다. KoKo라는 정신 상담 앱이 사용자에게 자세하게 고지하지 않고, GPT-3에 기반한 답변을 내담자에게 내어놓고 있고, DxGPT라는 웹사이트에서는 환자의 증상이나, 진료기록을 업로드하면 가능한 질병의 목록을 GPT-3에 기반하여 알려줍니다. (여러 기사에서 언급되었듯이) LLM이 정신 질환 환자들과 대화하다가 자살을 권유한다거나, Bing이 사용자를 위협한다던가..하는 것을 떠올려보면, 이미 실질적인 위해 가능성이 대중에게 실존하고 있다고 해도 과언이 아닐 것 같습니다.

즉, 정리하자면 이렇습니다. LLM이 의학적인 목적으로 활용될 경우 이는 의료기기로 분류됩니다. 하지만 동시에, LLM이 가진 고유의 특성 때문에, 의료기기로 심사하는 것 자체가 어려울 것입니다. 의료기기여야만 하는데, 의료기기가 될 수도 없는, 이러지도 저러지도 못하는 상황인 것이지요. 그 와중에 LLM을 활용한 의료 서비스들은 이미 시장에 등장하고 있습니다.

앞으로 FDA와 식약처가 이 이슈로 골치가 좀 아프실 것 같습니다. 저는 아무리 머리를 굴려봐도 뾰쪽한 방법이 잘 떠오르지가 않습니다. 최근 구글의 Med-PaLM 논문을 보면, 다양한 의료 질문-답변 벤치마크 데이터셋을 구성해서, 여러 측면에서 인간 의사와 거의 동등한 퍼포먼스를 보인다.. 정도로 증명하고 있는데, 인허가를 이런 방식으로 하기도 어려울 것 같고요.

이 문제에 어떤 해결책이 있을까요? 해결책이 있기는 할까요..?

![[논문] LLM이 의료 전문가보다 의학 텍스트 요약을 더 잘 한다](https://www.yoonsupchoi.com/wp-content/uploads/2024/03/Untitled-8-140x90.png)

![[영상] 카카오 브레인의 배웅 최고 헬스케어 책임자(CHO) 님 인터뷰](https://www.yoonsupchoi.com/wp-content/uploads/2024/03/배웅-부사장님-140x90.jpg)

![[공지] DHP 디지털 헬스케어 아카데미 2024 (6기)의 수강생을 모집합니다!](https://www.yoonsupchoi.com/wp-content/uploads/2024/02/홈페이지-메인배너-이미지-copy-140x90.jpg)